深度学习驱动的二指抓取策略生成方法

研究背景与意义

机器人抓取 机器人抓取是机器人学与自动化领域的一项核心研究课题,其重要性主要体现在以下几个方面。首先,抓取能力是机器人实现物理交互的基础,无论是工业流水线上的装配、物流分拣,还是家庭服务中的物品拿取,都需要机器人精准、稳定地操作物体。随着智能制造和柔性生产需求的增长,传统固定夹具已无法适应多样化、小批量生产的需求,而智能抓取技术能通过感知与决策实现自适应操作,显著提升生产效率和灵活性。其次,机器人抓取的研究推动着多学科交叉创新,涉及机械设计、计算机视觉、控制理论以及人工智能等领域的融合。此外,在危险环境(如核辐射区域、深海勘探)或特殊场景(如医疗手术辅助)中,可靠的自主抓取未来能替代人类完成高风险、高精度任务。

二指抓取 在机器人抓取研究中,二指抓取因其基础性与普适性成为重点研究方向。首先,二指结构抓取器,拥有简单的驱动与控制系统的同时,能覆盖大部分规则形状物体的操作需求。它的力学模型清晰,可通过接触力分析和稳定性判据量化抓取质量,这为算法研究提供了可靠的理论框架。实际应用中,二指抓取器因其轻量化、低成本和高可靠性,在工业场景中占据主导地位。因此,研究二指抓取兼具理论意义与工程价值,是推动机器人操作能力发展的关键切入点。

深度学习 近些年深度学习在二指抓取研究中具有显著优势,这些优势主要体现在以下几个方面。首先,传统的抓取规划方法在面对复杂、非结构化环境时往往计算效率低、适应性差,而深度学习能够直接从海量数据(如物体点云、RGB-D图像或仿真抓取记录)中学习抓取策略,自动提取关键特征,进而大幅提升抓取规划的泛化能力。其次,与传统算法相比,深度学习可以端到端地优化整个抓取流程,从感知、决策到控制,实现各模块的无缝协同,避免了传统方法各个步骤中出现的误差累积。最后,深度学习的可扩展性使其能通过迁移学习、在线学习方法不断融合新数据)从而适应新物体或新场景,这对柔性制造、物流分拣等需要快速切换任务的应用至关重要。

研究现状

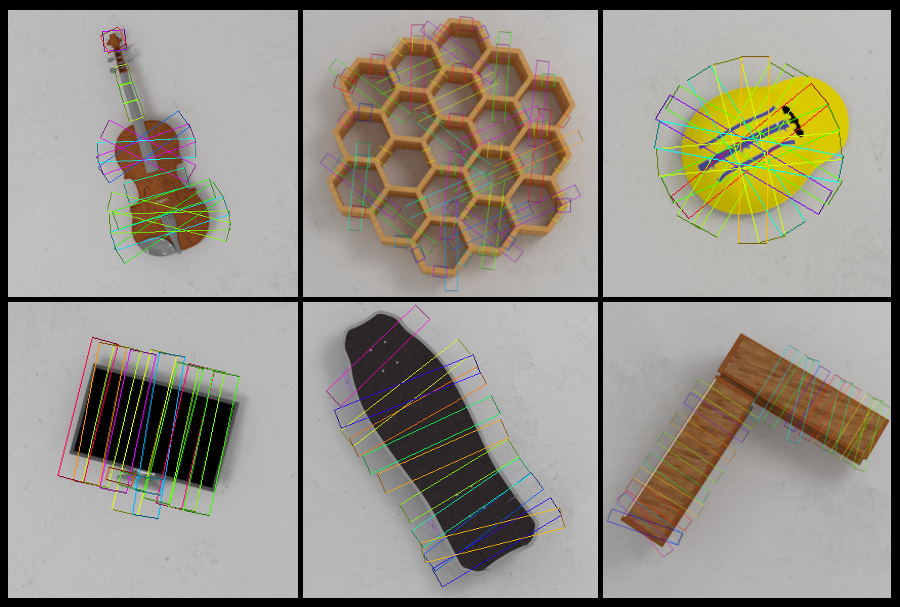

常用数据集

| 数据集名称 | 数据量 | 传感器类型 | 标注方式 | 物体类型 | 场景复杂度 |

|---|---|---|---|---|---|

| Cornell | 885 张图像 | RGB-D (Kinect v1) | 抓取矩形框 + 质量评分 | 单物体(15类日常物品) | 实验室环境(简单背景) |

| Jacquard | 54,000 次抓取 | 合成深度图 | 抗干扰抓取矩形 + 6D位姿 | 11,000+ 3D模型(多样化) | 虚拟环境(无噪声) |

| OCID | 2,300 个场景 | RGB-D (RealSense) | 实例分割 + 抓取成功率标签 | 日常物品(多物体堆叠) | 真实杂乱场景 |

常用方法

基于CNN的方法 卷积神经网络(CNN)在机器人视觉抓取任务中得到了广泛应用[1]。Lenz等人早期提出了一种两步级联系统,采用两个深度神经网络预测物体的抓取位姿。该方法首先生成大量候选抓取位姿,随后在第二步中重新评估,导致检测速度显著下降[2]。后续研究利用CNNs通过预测抓取矩形来提升抓取性能。Redmon等人提出了一种单阶段回归模型,实现了实时抓取检测[3]。为进一步提高精度,基于ResNet-50的抓取检测器被引入,在Cornell RGB-D数据集上表现出优越性能[4]。Jacquard[5]和Multi-Object[6]等数据集的提出,增强了CNN模型在抓取检测中的准确性和泛化能力。此外,专为深度图像设计的生成式抓取CNN(GGCNN)在实时场景中优化了逐像素抓取质量。Kumra等人提出的GR-ConvNet[7]采用n通道输入检测对握抓取,在Cornell和Jacquard数据集上实现了高精度。尽管基于CNN的方法在抓取检测中表现优异,但其固有缺陷在于堆叠卷积层会导致全局上下文信息丢失[2]。

基于ViT的方法 受Vision Transformer在目标检测和图像分类中成功的启发,近些年究者们开始探索其在机器人抓取位姿预测中的潜力[2][8]。Wang等人[2]率先提出将Swin-Transformer用于视觉抓取检测,通过编码器-解码器结构结合跳跃连接,生成像素级抓取表征。Dong等人[8]同样采用Swin-Transformer进行编码,并搭配全卷积解码器以提升检测性能。Yenicesu等人[9]近期提出的LITV2模型,则利用轻量化ViT实现了实时抓取检测。与CNN方法相比,基于ViT的方法展现出了更高的抓取检测精度。

参考文献

- [1]A. S. Yenicesu, B. Cicek, and O. S. Oguz, “FViT-Grasp: Grasping Objects With Using Fast Vision Transformers,” arXiv preprint arXiv:2311.13986, 2023.

- [2]S. Wang, Z. Zhou, and Z. Kan, “When transformer meets robotic grasping: Exploits context for efficient grasp detection,” IEEE robotics and automation letters, vol. 7, no. 3, pp. 8170–8177, 2022.

- [3]M. Dong, Y. Bai, S. Wei, and X. Yu, “Robotic grasp detection based on transformer,” in International Conference on Intelligent Robotics and Applications, 2022, pp. 437–448.

- [4]D. Morrison, P. Corke, and J. Leitner, “Learning robust, real-time, reactive robotic grasping,” Int. J. Rob. Res., vol. 39, no. 2–3, pp. 183–201, Mar. 2020.

- [5]S. Kumra, S. Joshi, and F. Sahin, “Antipodal robotic grasping using generative residual convolutional neural network,” in 2020 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), 2020, pp. 9626–9633.

- [6]A. Depierre, E. Dellandréa, and L. Chen, “Jacquard: A large scale dataset for robotic grasp detection,” in 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), 2018, pp. 3511–3516.

- [7]F.-J. Chu, R. Xu, and P. A. Vela, “Real-world multiobject, multigrasp detection,” IEEE Robotics and Automation Letters, vol. 3, no. 4, pp. 3355–3362, 2018.

- [8]S. Kumra and C. Kanan, “Robotic grasp detection using deep convolutional neural networks,” in 2017 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), 2017, pp. 769–776.

- [9]J. Redmon and A. Angelova, “Real-time grasp detection using convolutional neural networks,” in 2015 IEEE international conference on robotics and automation (ICRA), 2015, pp. 1316–1322.